Facebook ha dichiarato di aver rimosso, nelle prime 24 ore dalla strage, oltre 1.5 milioni di video del massacro di Christchurch, di questi ne ha bloccati 1.2 milioni già in fase di upload. Nella differenza tra il termine “bloccato” e il termine “rimosso” risiede tutta l’impotenza attuale e futura del social network.

La “rimozione” arriva dopo che il video è andato già online ed è stato visto, dopo che con molta probabilità è stato anche condiviso e forse scaricato. Il blocco agisce invece alla radice, prima che venga caricato su un profilo oppure su una pagina.

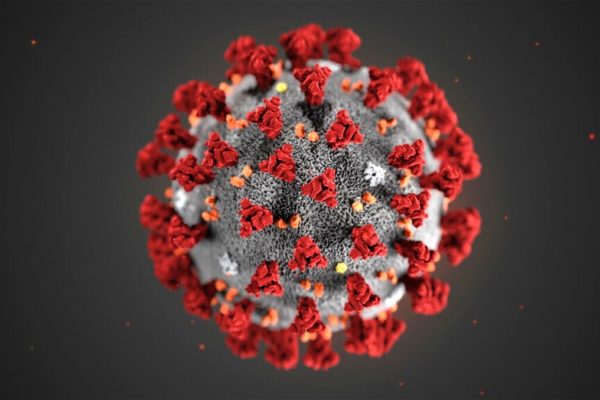

Insomma Facebook ha realizzato un’operazione meritoria e tuttavia inutile. Un 20% dei video può essere sfuggito all’intelligenza artificiale che non lo ha riconosciuto, né intercettato e quindi lo stesso video potrebbe essere finito in circolo, per usare un termine medico, portando le tossine di Christchurch a spasso per un sistema globale e permeabile, per statuto. Un 20% che significa numeri importanti: visualizzazioni e persone che lo hanno visto, ne hanno sofferto o l’hanno utilizzato per diffondere le convinzioni criminali del terrorista australiano.

Tra l’altro queste pericolose tossine circolano, non solo e non tanto, sui social network, che alla fine posseggono alcuni anticorpi, quanto all’interno dei servizi di messaggistica, nei gruppi, nelle chat private come quelle in cui ciascuno di noi è iscritto per differenti ragioni. E questi servizi di messaggistica sono anche protetti da sistemi di crittografia end-to-end, è il caso di WhatsApp, per esempio. Cioè sono protetti in maniera tale che nessuno, a eccezione di chi si sta scambiando messaggi, possa leggere il contenuto di quei messaggi.

Le tossine di Christchurch purtroppo non fanno altro che ribadire l’impossibilità del controllo a tappeto su contenuti illegali. Facebook è come una strada: in questa strada – purtroppo – si incontra chiunque, persone tranquille, persone per bene, altruiste o generose ma si incontrano anche criminali di ogni sorta, compresi i terroristi; se i terroristi cercano di diffondere le proprie atroci e aberranti convinzioni in questa strada, la soluzione non è e non può essere quella di chiudere l’accesso alla strada. sarebbe una soluzione sbagliata e inutile. Quelle stesse persone troverebbero nuovi spazi e altri luoghi in cui commettere reati. Con lo stesso principio di realtà, dobbiamo quindi affermare che non tutte le strade sono e possono essere considerate sicure. Allo stesso tempo, con la stessa onestà, è necessario affermare che il social network non potrà mai trasformarsi in un posto sicuro al 100%, non potrà mai, e fino in fondo, essere totalmente efficiente nel controllo e nella rimozione di contenuti illegali.

L’ossessione securitaria rimane un’ossessione nella vita fisica come in quella digitale.

In un ultimo, lungo, post di qualche giorno fa dal titolo Una visione incentrata sulla privacy per i social network, Mark Zuckerberg ha detto – insieme a molte altre cose – di voler potenziare i sistemi di messaggistica. Anzi, ha precisato che egli vuole favorire l’interoperabilità tra i differenti sistemi e servizi. Il fondatore di Facebook ha dunque lasciato immaginare, di qui a qualche anno, un unico grande spazio di chat che sia la sintesi del Messenger di Facebook, di WhatsApp e di Instagram. Lì dentro, come in un salotto, le persone parleranno e si confronteranno sentendosi al sicuro, protette, riparate. E lì dentro potranno far circolare e condividere immagini private e contenuti sensibili, senza alcun timore, senza che nessuno ficchi il naso nelle conversazioni intime delle persone.

Se era già difficile immaginare un controllo per 2.2 miliardi di persone che condividono contenuti in uno spazio semi-aperto com’è Facebook, sarà pressoché impossibile farlo in uno spazio chiuso. Sarà pressoché impossibile, insomma, controllare e rimuovere il video di un terrorista che riprende se stesso mentre realizza una strage, se questo contenuto si moltiplica di gruppo chiuso in gruppo chiuso, di chat in chat. Sia che i partecipanti di un gruppo vogliano limitarne la circolazione – ci sarà sempre qualcuno che lo inoltrerà – sia che i partecipanti, al contrario, vogliano diffonderlo.

È vero che Facebook è riuscito a bloccare un 80% di video, ma quel restante 20% ha una densità enorme e il peso specifico dell’ammissione di un’impotenza sistemica. Dopotutto la sindrome del controllo è un limite sia per gli esseri umani che per le techno-corporation.

Oggi stiamo assistendo a un fenomeno che – si parva licet – ricorda gli esperimenti che i fisici fanno negli acceleratori di particelle. Lì dentro, ovviamente, non si vedono le particelle elementari, ma gli effetti delle collisioni che avvengono tra le particelle. Il nostro destino, il destino delle società alle prese con contenuti sigillati ermeticamente in quegli acceleratori di particelle che sono i gruppi chiusi dei sistemi di messaggistica, è quello di osservarne gli effetti solo dopo che questi si sono prodotti. Osservarne gli sconquassi, e noi esseri umani siamo vittime di quelle collisioni, ma potremo misurarne la portata solo dopo. A cose fatte.